想自己做 AI Agent?收好这份大语言模型模型指南

作者:superoo7

编译:深潮TechFlow

几乎每天我都会收到类似的问题。经过帮助构建超过 20 个 AI 智能体并在测试模型上投入了大量成本后,我总结出了一些真正有效的经验。

以下是关于如何选择合适 LLM 的完整指南。

目前的大语言模型 (LLM) 领域变化迅速。几乎每周都有新模型发布,每个模型都声称自己是“最好的”。

但现实是:没有一种模型能够满足所有需求。

每种模型都有其特定的适用场景。

我已经测试了数十种模型,希望通过我的经验,能让你避免不必要的时间和金钱浪费。

需要说明的是:这篇文章并非基于实验室的基准测试或营销宣传。

我将分享的是基于过去两年中,亲手构建 AI 智能体和生成式 AI (GenAI) 产品的实际经验。

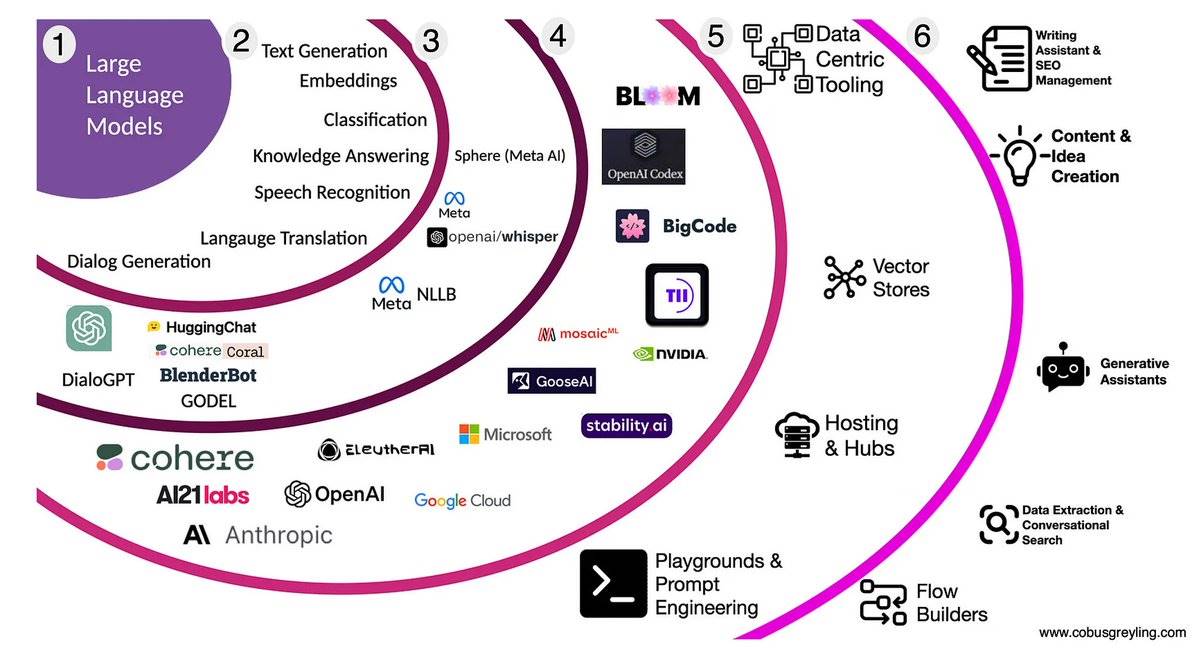

首先,我们需要了解什么是 LLM:

大语言模型 (LLM) 就像是教会计算机“说人话”。它根据你输入的内容,预测接下来最可能出现的单词。

这一技术的起点是这篇经典论文:Attention Is All You Need

基础知识——封闭源代码与开放源代码的 LLM:

-

封闭源代码:例如 GPT-4 和 Claude,通常按使用量付费,由提供商托管运行。

-

开放源代码:例如 Meta 的 Llama 和 Mixtral,需要用户自行部署和运行。

刚接触时,可能会对这些术语感到困惑,但理解两者的区别非常重要。

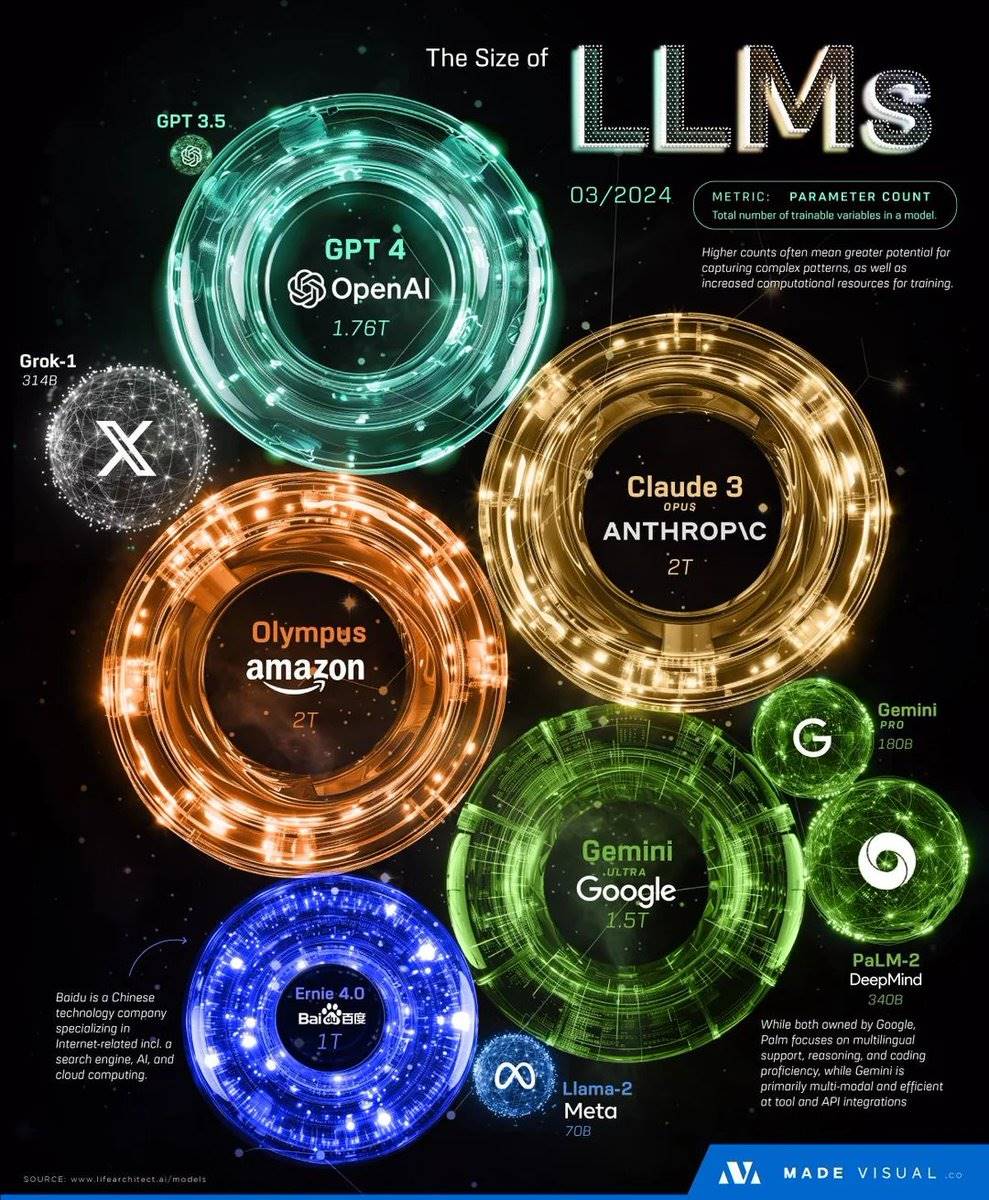

模型规模并不等于性能更好:

比如 7B 表示模型有 70 亿个参数。

但更大的模型并不总是表现更优。关键在于选择适合你具体需求的模型。

如果你需要构建 X/Twitter 机器人或社交 AI:

@xai 的 Grok 是一个非常不错的选择:

-

提供慷慨的免费额度

-

对社交语境的理解能力出色

-

虽然是封闭源代码,但非常值得尝试

强烈推荐刚入门的开发者使用这个模型!(小道消息:

@ai16zdao 的 Eliza 默认模型正在使用 XAI Grok)

如果你需要处理多语言内容:

@Alibaba_Qwen 的 QwQ 模型在我们的测试中表现非常出色,尤其是在亚洲语言处理方面。

需要注意的是,该模型的训练数据主要来自中国大陆,因此某些内容可能会有信息缺失的情况。

如果你需要通用用途或推理能力强的模型:

@OpenAI 的模型依然是行业中的佼佼者:

-

性能稳定可靠

-

经过广泛的实际测试

-

拥有强大的安全机制

这是大多数项目的理想起点。

如果你是开发者或内容创作者:

@AnthropicAI 的 Claude 是我日常使用的主力工具:

-

编码能力相当出色

-

响应内容清晰且详细

-

非常适合处理创意相关的工作

Meta 的 Llama 3.3 近期备受关注:

-

性能稳定可靠

-

开源模型,灵活自由

-

可以通过 @OpenRouterAI 或 @GroqInc 进行试用

例如,@virtuals_io 等加密 x AI 项目正基于它开发产品。

如果你需要角色扮演类的 AI:

@TheBlokeAI 的 MythoMax 13B 是目前角色扮演领域的佼佼者,已经连续数月在相关排名中名列前茅。

Cohere 的 Command R 是一个被低估的优秀模型:

在角色扮演任务中表现出色

能够轻松应对复杂任务

支持长达 128000 的上下文窗口,拥有更长的“记忆能力”

Google 的 Gemma 模型是一个轻量级但功能强大的选择:

-

专注于特定任务,表现优异

-

预算友好

-

适合成本敏感的项目

个人经验:我经常使用小型 Gemma 模型作为 AI 流程中的“无偏见裁判”,在验证任务中效果非常出色!

Gemma

@MistralAI 的模型值得一提:

-

开源但具备高端质量

-

Mixtral 模型的性能非常强劲

-

特别擅长复杂推理任务

它受到社区的广泛好评,绝对值得一试。

你手中的前沿 AI。

专业建议:尝试混合搭配!

-

不同模型各有优势

-

可以为复杂任务创建 AI “团队”

-

让每个模型专注于它最擅长的部分

就像组建一支梦之队,每个成员都有独特的角色和贡献。

如何快速上手:

使用 @OpenRouterAI 或 @redpill_gpt 进行模型测试,这些平台支持加密货币支付,非常方便

是比较不同模型性能的绝佳工具

如果你希望节省成本并在本地运行模型,可以尝试使用 @ollama,通过自己的 GPU 进行实验。

如果你追求速度,@GroqInc 的 LPU 技术提供了极快的推理速度:

-

虽然模型选择有限

-

但性能非常适合生产环境的部署